13/11/2017 - Un oeil sur les médias

Par Maëlle Fouquenet,

journaliste responsable des formations numériques ESJPRO

En avril 2017, Google annonçait des modifications de son moteur de recherche afin de limiter la visibilité des fausses nouvelles. Idem pour Facebook. Au lendemain de la tuerie de Las Vegas le 1er octobre de la même année, Google, Facebook et Twitter ont pourtant envoyé les internautes vers des sites diffusant des fausses informations. De quoi relancer le débat sur leur rôle et leur responsabilité dans la diffusion des “fake news”, ainsi que sur les réponses qu’on peut y apporter.

Pour faire face au déferlement d’informations plus ou moins bidons, de “vérité alternative” et mensonges en tout genre, il faut comprendre pourquoi les internautes les partagent. Et cela, même quand ils savent pertinemment qu’elles sont fausses.

Pour agir, trois leviers au moins peuvent être utilisés (c’est déjà le cas de certains) : le premier éditorial pourrait être actionné par les médias, le deuxième technique est du ressort des plateformes, et le dernier est de la compétence des institutions politiques.

Les réponses éditoriales

- faire attention aux visuels, images, vidéos et mèmes qui paraissent inoffensifs, “pas sérieux”, et qui circulent beaucoup plus vite que le texte

- répondre avec les mêmes “armes” (mèmes, vidéos amusantes…) car c’est ça que l’algorithme de Facebook met en avant

- être créatif dans la diffusion des “débunkages” (la démythification des fausses informations)

> le faire même si ce rappel des faits véritables ne change pas les points du vue des lecteurs ? - faire attention aux titres et images utilisés dans les débunkages (Claire Wardle explique qu’au début de CrossCheck, les titres reprenaient les fausses nouvelles mais étaient réutilisés de manière contre-productive)

- replacer les fausses nouvelles dans une narration différente de celle d’origine (exemple : certains sites ont indiqué qu’Obama est musulman, ce qui est faux. Au lieu de nier et contredire, mieux vaut affirmer. Dans cet exemple, affirmer sa religion, la tournure positive marquant plus les esprits)

- agir sur les communautés de lecteurs, les valoriser, en faire des ambassadeurs car c’est leur crédibilité qui porte la marque

- proposer des jeux et quiz “intelligents” pour développer la curiosité du public (les personnes curieuses ont plus tendances à croire les faits avérés que les autres), cf You draw it, du New York Times

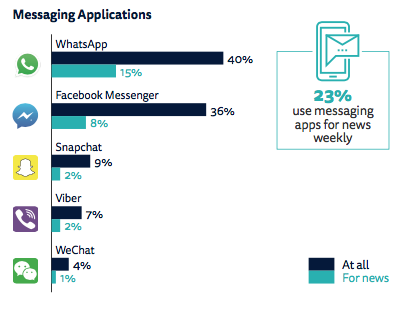

- regarder là où les médias ne sont pas encore : les messageries type Whatsapp et Messenger sont utilisées pour recevoir de l’information (cf graphique ci dessous), les groupes, forums et chatrooms privés.

Les réponses techniques

- réduire le nombre de posts ? Diego F.M. Oliveira s’appuie sur le fait qu’une partie significative sur contenu problématique est postée par des bots dont la capacité de production submerge les plateformes.

> ce serait une façon mécanique d’endiguer la masse de fausses informations, mais il est probable que le nombre de faux comptes et de bots augmenterait en réponse.

> en revanche, on peut s’interroger sur le comportement et les choix de publications et partages des humains s’ils étaient limités en nombre de posts journaliers. Seraient-ils plus attentifs aux contenus qu’ils partagent ?

- distinguer graphiquement les posts des médias “classiques” des autres posts, car comme le dit Claire Wardle, “là le cerveau met tout sur le même plan”.

> les éditeurs pourraient réclamer un traitement graphique spécifique aux plateformes de publication. Aux Etats-Unis, ils s’unissent pour négocier avec les géants du web

> Facebook annonce intégrer le logo des médias dans les résultats de recherche et trendings mais expérimente dans certains pays des modifications dans les murs des usagers qui masquent les contenus des médias dans un nouvel onglet, avec pour résultat immédiat une chute spectaculaire du trafic sur les sites des médias dans ces pays

- supprimer les faux comptes qui servent de rampe de lancement pour la diffusion de fausses nouvelles (ce que Facebook annonce avoir entamé en France aussi)

- modifier les algorithmes des plateformes

> en avril 2017, Google communique sur son projet Owl, qui doit faire descendre les résultats peu fiables dans les résultats de recherche. Facebook annonce des modifications similaires et même une baisse de 80% de l’impression des contenus étiquetés “fake” par les partenaires médias. Problème : cet étiquetage prend en moyenne trois jours, et c’est dans ce laps de temps que le partage est le plus intense.

> en octobre 2017, la suite de la tuerie de Las Vegas, des liens vers des sites diffusant de fausses informations sont relayés en tête des résultats de recherche de Google ou dans les liens d’actualité du safety check de Facebook, cela malgré les modifications d’avril

> Quelles modifications ont été apportées exactement ?

> Malgré des partenariats avec les médias dans le cadre de dispositifs de fact checking, les plateformes continuent de véhiculer des fausses informations. Une intervention humaine reste impérative

- interdire l’accès aux publicités Facebook pour les annonceurs identifiés comme auteur de fake news afin de limiter la circulation de leurs contenus

- développer une modération automatique des commentaires ?

> pour le moment, la technologie ne peut qu’être une aide aux modérateurs humains, mais pas les remplacer

> il faudrait que le “final cut” des règles de modérations reviennent aux journalistes et non pas aux ingénieurs

Les réponses éducatives et sociales

- éduquer et développer une pensée critique (exemple des cours “Calling bullshit” de l’université de Washington)

> questionner le pourquoi de la croyance fausse

> s’assurer que les générations futures comprennent comment fonctionnent la technologie, les médias et les réseaux sociaux, comment ils peuvent être influencés - sortir de l’effet de groupe et essayer de ne pas se laisser définir par ses croyances

- rendre socialement inacceptable le partage de ses fausses information

- réduire les failles du discours, expliquer avec plus de transparence pour agir sur les croyances

La responsabilité des plateformes et l’importance des actions institutionnelles

Face à ce phénomène des fake news, mais aussi de manière général dans un monde qui se numérise, il est primordial que les humains continuent de diriger, que ce soit dans les décisions politiques ou éditoriales. Claudio Guarnieri, chercheur en sécurité informatique, appelle à ne pas laisser le fatalisme et le solutionnisme technologiques prendre le pas sur la décision politique humaine :

“La technologie doit être comprise, pas crue sans questionnement.”

Franck Pasquale, professeur de droit et auteur de The black box society, veut lui aussi faire face au discours couramment entendu dans les milieux technologiques “qui dit que la loi ne peut pas s’adapter à l’évolution des technologies”.

Il est également de plus en plus difficile de se satisfaire de la parole des acteurs technologiques sur les paramétrages des algorithmes alors que ceux-ci continuent de mettre en avant des liens vers des sites diffusant des fausses informations, et cela malgré leur engagement à les combattre. En effet, aucun tiers n’a la possibilité de vérifier ces modifications, nous sommes tenus de croire les communiqués de presse et déclarations. Comment cela est-il améliorable ?

Des voix montent pour obtenir des plateformes technologiques plus de transparence des algorithmes “et un accès aux logs pour trouver rapidement les sources des rumeurs”, comme dans le pizzagate, explique Franck Pasquale lors de sa conférence à RePublica en mai 2017. Car, comme ils le font systématiquement, Google et Facebook peuvent-il se distancer des résultats de recherche et partages sans prendre de responsabilité ?

Certains vont plus loin et posent la question d’une nationalisation de Facebook ou Google. Dans Libération, Olivier Ertzscheid souligne d’ailleurs qu’ “on passe de modèle de délégation de service public à des modèles de délégation de responsabilité publique”.

Quid de la liberté d’expression ?

Toutes ces interrogations appellent à une réflexion sur le devenir de la sphère publique dans le futur. Qui pour la définir ? Pour l’animer ? Pour la réguler ? Et avec cette notion de sphère publique, quel avenir pour la liberté d’expression ?

Comment contrer la viralité extrêmement rapide et massive des fake news sans mettre à mal cette liberté fondamentale à toute démocratie ? Pour Claudio Guarnieri, “il faut trouver des réponses proportionnées à ces phénomènes. Ce n’est pas en filtrant qu’on évitera la bigoterie et le populisme.”

Les entreprises qui sont maintenant en position de réguler les publications sur les plateformes les plus utilisées sont toutes américaines : Google, Apple, Amazon, Facebook, Microsoft (GAFAM), Twitter….

Pétries d’une vision de la liberté d’expression associée à une économie de marché libérale, ces entreprises régissent les contenus selon leur conception de la morale. Franck Pasquale parle de “fondamentalisme du 1er amendement” (amendement qui garantit la liberté d’expression aux Etats-Unis et derrière lequel se retranche les GAFAM pour éviter de modérer une partie des contenus).

Or, cette vision de la liberté d’expression est éminemment culturelle. Pasquale défend l’idée de réponses nationales prenant en compte cette dimension culturelle dans la lutte contre les discours de haine et les fausses nouvelles. Il insiste aussi sur l’importance de ne pas empêcher des régulations étatiques et transparentes.

L’Allemagne a d’ailleurs voté le 30 juin 2017 une loi obligeant les réseaux sociaux à supprimer les contenus haineux, loi qui s’applique aux fausses nouvelles. En France, l’article 27 de la loi sur la liberté de la presse de 1881, l’article L97 du code électoral, mais aussi des articles du code pénal, du code du commerce, du code monétaire et financier, ou encore du code de la santé publique, permettent de s’attaquer aux auteurs de fausses nouvelles sous certaines conditions.

Mais agir sur les auteurs des fausses nouvelles — quand ils sont identifiables — n’en freine pas le partage. Considérer les plateformes comme des éditeurs et donc les soumettre aux mêmes lois serait-il une solution ? C’est ce que réclame notamment Eric Hellweg, de la Harvard Business Review et Konrad Niklewicz, qui a rédigé un rapport sur les fake news pour le centre européen Wilfried Martens (Think tank du Parti populaire européen).

Malgré son refus obstiné de considérer Facebook comme un média “classique”, Mark Zuckerberg a tout de même reconnu une responsabilité dans la façon dont sa plateforme est utilisée. “On ne fait pas que distribuer du contenu”, a-t-il concédé dans sa vidéo de la fin d’année 2016. Un pas qui n’a, presqu’un an plus tard, pas mené bien loin.